وجه العديد من الأشخاص الاتهامات لأداة ذكاء اصطناعى يمكنها تحويل الصور الأقل جودة "التي يتضح فيها تقسيمات البكسل" إلى صور واضحة، بالتحيز العنصرى ضد ذوى البشرة الداكنة، فلم تكن قادرة على معالجة الوجوه السمراء.

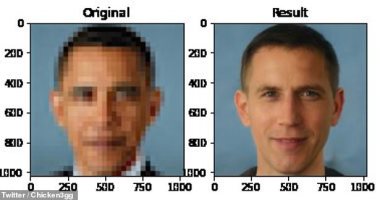

وفقا لما ذكرته صحيفة "ديلى ميل" البريطانية، انتشر الحديث حول الأداة التي تسمى Face Depixelizer على تويتر ليختبرها المستخدمون، الذين وجدوا أن التقنية غير قادرة على معالجة الوجوه ذات البشرة الداكنة بشكل صحيح، حيث حولت الأداة صورة لباراك أوباما إلى رجل أبيض.

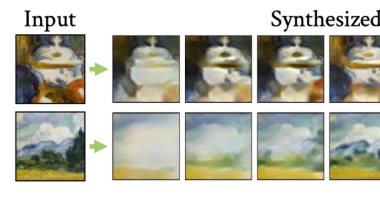

ويعتمد Face Depixelizer على أداة الذكاء الاصطناعي التي طورها فريق في جامعة ديوك، والتي تستخدم طريقة تسمى PULSE التي تبحث من خلال الصور التي تم إنشاؤها بواسطة الذكاء الاصطناعى AI لوجوه عالية الدقة لتطابق تلك التي تبدو مشابهة للصورة المدخلة عند ضغطها على نفس الحجم.

استخدم فريق الباجثين بلجامعة ديوك، أداة للتعلم الآلي مع شبكتين عصبيتين، فواحدة منهم تطور الوجوه البشرية التي تخلق الذكاء الاصطناعي، والتي تحاكي تلك التي تم تدريبها عليها، والأخرى تأخذ هذا الناتج وتقرر ما إذا كان مقنعًا بما يكفي ليتم الخلط بينه وبين الشيء الحقيقي.

تفاخرت جامعة ديوك بأن نظامها قادر على تحويل صورة 16 × 16 بكسل إلى 1024 × 1024 بكسل في بضع ثوانٍ، وهو ما يعادل 64 ضعف الدقة.

أجرى روبرت أوسازوا نيس، وهو مدون للتعلم الآلي، اختبارًا لصورتين وأنتجت النتائج وجوهًا تبدو بيضاء بالكامل لأشخاص ليسوا كذلك.

فيما أشار Business Insider إلى أن الفشل قد يكون بسبب مجموعة البيانات المستخدمة لتدريب الذكاء الاصطناعي، فإذا كان هناك نقص في التنوع في الصور التي يتم إدخالها إلى خوارزمية التعلم الآلي، فلن تتمكن من الأداء بشكل صحيح.

وكان أصدر باحثو معهد ماساتشوستس للتكنولوجيا تقريرًا في عام 2018 يكشف عن الطريقة التي يجمع بها نظام الذكاء الاصطناعي البيانات، والتي غالبًا ما تكون عنصرية وجنسية.

قالت الباحثة الرئيسية إيرين تشين، طالبة الدكتوراه التي كتبت الورقة مع أستاذ معهد ماساتشوستس للتكنولوجيا ديفيد سونتاج وزميل ما بعد الدكتوراه فريدريك يوهانسون: "غالبًا ما يسارع علماء الكمبيوتر إلى القول بأن الطريقة لجعل هذه الأنظمة أقل انحيازًا هي ببساطة تصميم خوارزميات أفضل ".

وأضافت الباحثة: "لكن الخوارزميات جيدة فقط عند استخدام البيانات المناسبة، ويظهر بحثنا أنه يمكنك غالبًا إحداث فرق أكبر ببيانات أفضل."